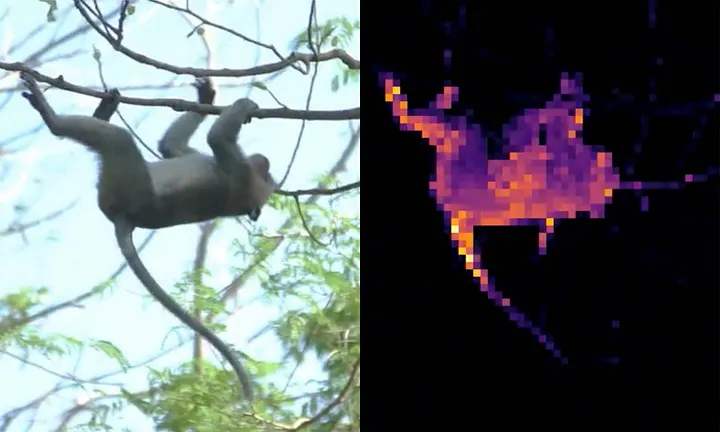

Cut and learn 방식으로 작은 물체까지 잘 잡아냄

Cut and Learn for Unsupervised Object Detection and Instance Segmentation

If you find our work inspiring or use our codebase in your research, please cite our work: @article{wang2023cut, author={Wang, Xudong and Girdhar, Rohit and Yu, Stella X and Misra, Ishan}, title={Cut and Learn for Unsupervised Objec

people.eecs.berkeley.edu

Abstract

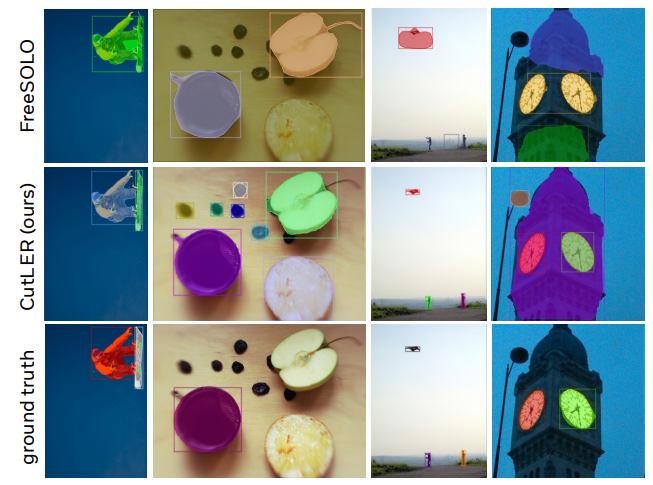

Unsupervised object detection 및 segmentation 모델을 훈련하기 위한 간단한 접근법인 Cut-and-LEaRn(CutLER) 제안.

MaskCut 접근 방식을 사용하여 여러 개체에 대한 coarse mask를 생성한 다음 마스크에 대한 탐지기 학습.

CutLER은 다양한 탐지 아키텍처와 호환되며 여러 개체를 탐지한다.

Introduction

CutLER은 downstream 작업에 활용하기 위한 이전의 자체 지도 방법들과 달리 detection 및 segmentation에 직접 사용될 수도 있다.

- 먼저 사전 훈련된 자체 지도 기능으로 coarse mask를 자동으로 생성하는 MaskCut 제안

- MaskCut이 놓친 물체에 견고하면서 coarse mask를 통해 탐지기를 훈련하는 loss drop 전략 제안

- Coarse mask에 대해 학습했음에도 불구하고 탐지기는 훨씬 더 나은 mask 및 box를 생성할 수 있다.

CutLER의 특징:

- 단순성 : 교육하기 쉽고 다른 detection 및 segmentation 작업에 쉽게 통합 가능

- 강력한 zero-shot 성능

- 견고성 : 다양한 도메인에 대해 강한 견고성을 보여줌

- Supervised detection을 위한 사전 훈련 모델 역할 가능

Method

Preliminaries

Normalized Cuts(NCut)

NCut은 graph data를 둘로 분할하기 위한 알고리즘이다.

DINO and TokenCut

DINO에서 self-supervised ViT가 패치의 지각적 그룹화를 자동으로 학습할 수 있다는 것을 발견했다.

TokenCut은 DINO의 각 패치를 graph data의 node로, 각 패치 간의 cosine 유사도를 edge의 가중치 W로 하고

NCut 알고리즘을 진행하여 foreground와 background를 분할하는 방법이다.

TokenCut의 치명적인 단점은 이미지당 하나의 객체만 탐지할 수 있다는 것이다.

MaskCut for Discovering Multiple Objects

본 논문에서 제안하는 MaskCut은 NCut을 반복적으로 적용하여 여러 객체를 탐지하는 방법이다.

t 단계에서 NCut으로 분리된 bi-partition을 얻고 마스크 Mt를 구성.

Mt가 두 번째로 작은 eigenvector의 최대 절댓값에 해당하는 패치가 포함되어 있는지 여부(NCut 관련) 등으로 foreground, background를 구분한다.

t+1 단계에서의 W(중첩마스크 적용, M̂ = 1 - M)

DropLoss for Exploring Image Regions

Detection loss는 ground-truth와 겹치지 않는 예측 영역 ri에 불이익을 주고, 이것은 label이 부착되지 않은 새로운 인스턴스를 발견하지 못하게 한다.

따라서 ground-truth와 임계값 이상으로 겹치지 않는 예측 영역에 대한 loss는 drop한다.

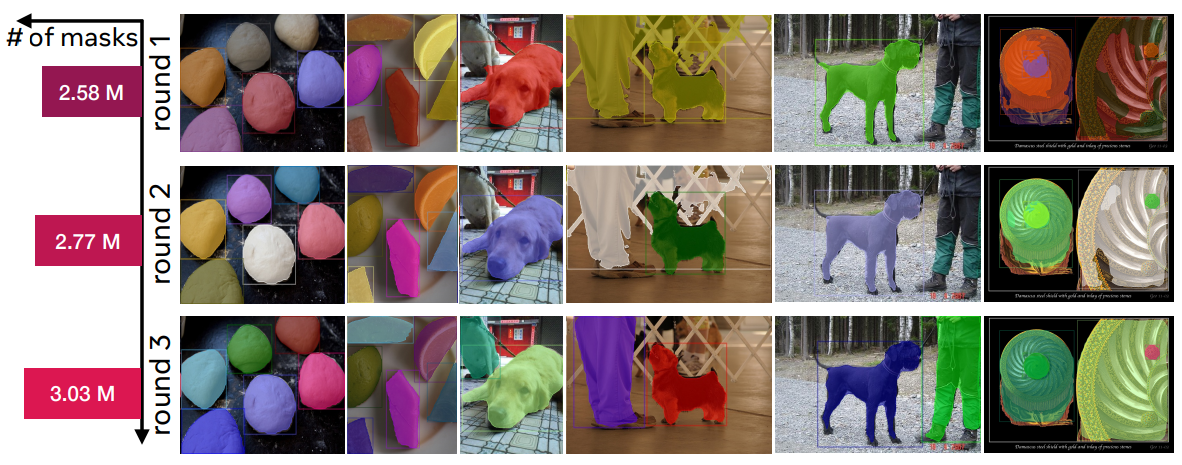

Multi-Round Self-Training

탐지 모델이 마스크 품질을 개선하고 DropLoss 전략이 새로운 객체를 발견하도록 권장하기 때문에 여러 차례의 self-training을 통해 이 특성을 최대한 활용한다.

Self-training의 t 단계에서 0.75-0.5t 이상의 신뢰 점수를 가진 마스크와 제안을 다음 단계에 대한 추가적인 pseudo annotation으로 사용. t+1 단계에서 예측과 pseudo annotation을 병합하고 중복 제거.

Self-training 동안 ground-truth sample이 꾸준히 증가함.

Experiments

조그만 물체까지 잘 잡아낸다.

'논문 리뷰 > Vision Transformer' 카테고리의 다른 글

| Inpaint Anything: Segment Anything Meets Image Inpainting (0) | 2023.04.19 |

|---|---|

| Segment Anything (SAM) (0) | 2023.04.09 |

| Token Merging: Your ViT But Faster (0) | 2023.04.06 |

| Muse: Text-To-Image Generation via Masked Generative Transformers (2) | 2023.01.11 |

| Scalable Diffusion Models with Transformers (DiT) (0) | 2022.12.24 |

| MatteFormer : Transformer-Based Image Matting via Prior-Tokens 논문 리뷰 (0) | 2022.07.04 |