Text-to-image를 위한 VQ masked transformer

Abstract

Diffusion 또는 Autoregressive(AR) 모델보다 훨씬 효율적이면서 이미지 생성에서 SOTA를 달성한 text-to-image transformer 모델 Muse.

Muse는 사전 훈련된 대형 언어 모델에서 추출된 텍스트 임베딩을 고려해 무작위로 마스킹된 이미지 토큰을 예측하도록 훈련된다. 적은 샘플링 반복과 병렬 디코딩 사용으로 확산이나 AR 모델보다 빠르고 효율적이다.

Introduction

하위 모듈들

- 256, 512로 한 쌍의 VQGAN tokenizer

- 부분적으로 마스킹된 저해상도 토큰 시퀀스에서 마스킹되지 않은 토큰과 텍스트 임베딩에 따라 마스킹된 토큰에 대한 marginal distribution을 예측하는 MIM(masked image model)

- 저해상도 토큰을 고해상도 토큰으로 변환하는 superres transformer model

Stable diffusion, Parti와 같은 최신 확산, AR 모델보다 빠르고 효율적

본 논문의 기여

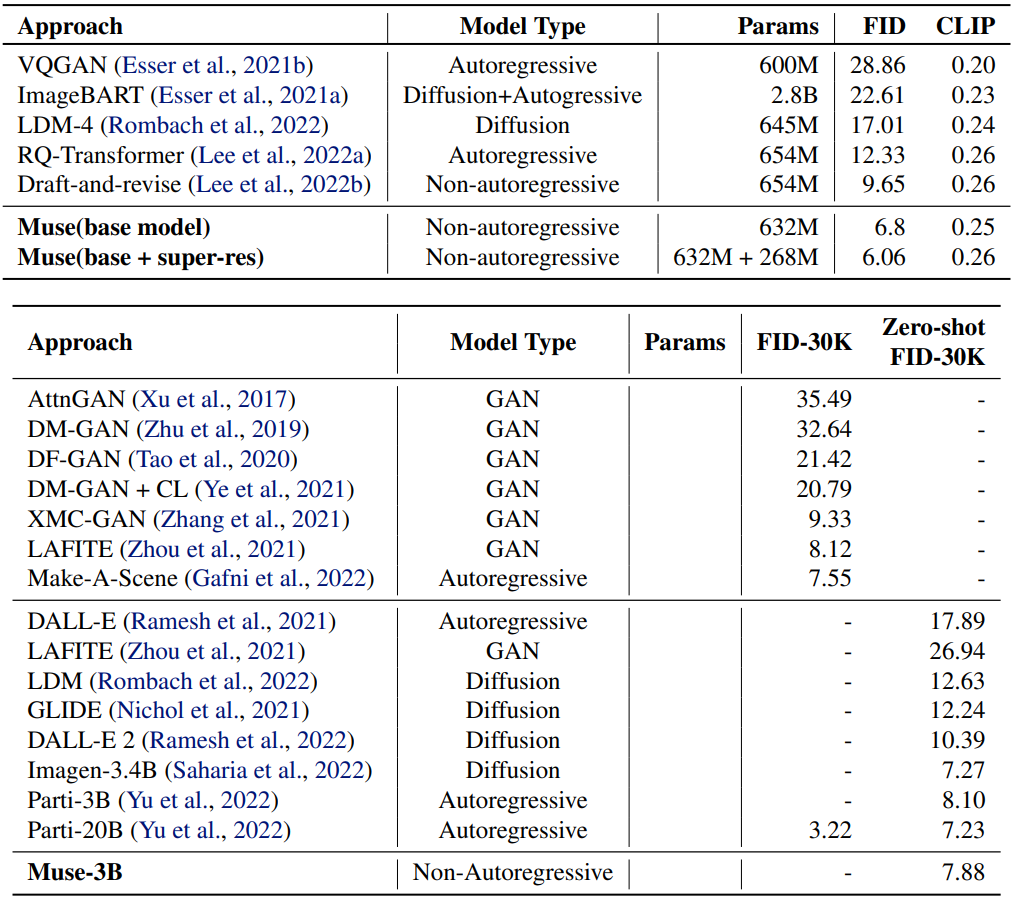

- 우수한 FID, CLIP score를 달성하는 text-to-image의 최첨단 모델 Muse

- 양자화된 이미지 토큰과 병렬 디코딩을 사용하기 때문에 빠르고 효율적

- Zero-shot 편집기능 제공

(MaskGIT ← 다른 분의 유튜브 영상인데, MaskGIT과 Muse 둘 다 구글에서 나온 논문이고 공통점이 매우 많기 때문에 보고 오는 것을 강추한다. 글보다 영상이 훨씬 더 잘 이해되기도 하고)

Model

Pre-trained Text Encoders

T5-XXL 인코더 사용

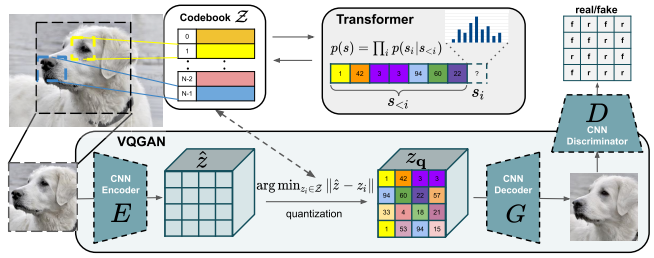

Semantic Tokenization using VQGAN

VQGAN으로 만든 저해상도, 고해상도 tokenizer 사용

출력에서 cross-entropy를 사용

Base Model

베이스는 masked transformer(e.g. BERT, MaskGIT)

훈련에서는 각 단계에서 모든 토큰을 예측

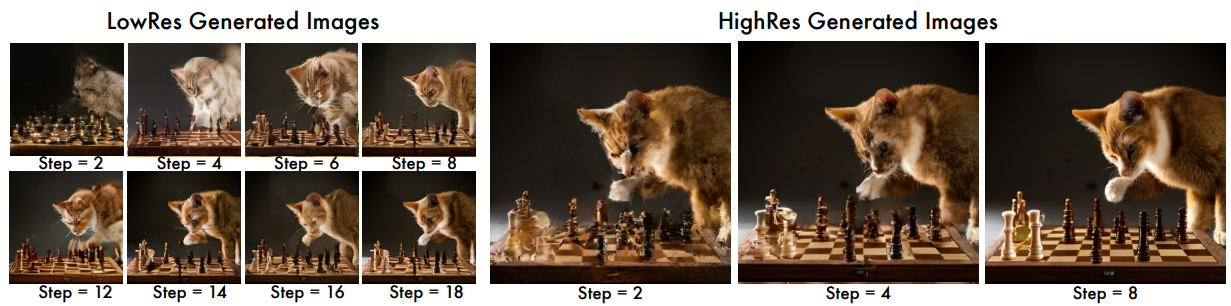

Super-Resolution Model

높은 해상도에서 직접 예측하면 세부사항에 초점을 맞추게 되기 때문에 일련의 모델 사용

Base model 훈련 후 훈련됨

저해상도 → 고해상도로 변환 후 VQGAN으로 디코딩

Decoder Finetuning

생성 품질 향상을 위해 VQGAN 디코더에 많은 잔차 연결과 채널을 추가하고 인코더, 코드북, transformer는 고정한 채 finetuning 한다.

Variable Masking Rate

MaskGIT에서와 같이 cosine scheduling을 기반으로 한 가변 masking rate r.

각 훈련 예제 당 r을 0~1에서 샘플링하고 cosine schedule을 적용한 확률로 마스킹한다.

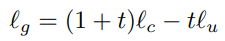

Classifier Free Guidance

훈련 샘플의 10%에서 텍스트 인코딩을 제거하고 Classifier-free guidance(CFG) 적용.

CFG는 생성 품질과 다양성이 trade-off 되는데, 샘플링 동안 t를 서서히 증가시킴으로써 다양성의 손해를 줄인다.

또한 무조건 로짓인 lu를 '부정적 프롬프트'에 대한 조건부 로짓으로 대체한다.

이는 출력 이미지가 lc의 특징을 가지는 동시에 lu의 특징을 제거하도록 유도함.

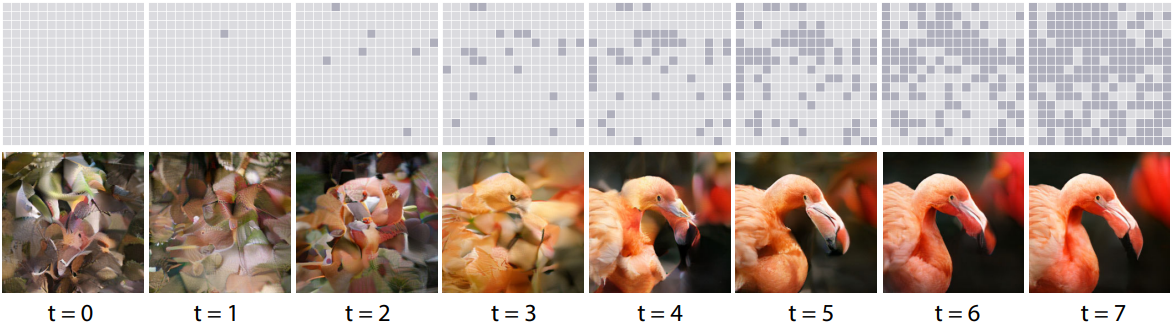

Iterative Parallel Decoding at Inference

각 단계에서 cosine scheduling에 기반하여 가장 신뢰도 높은 토큰 일부의 마스크를 해제

4096개의 토큰을 저해상도 24 + 고해상도 8개의 디코딩 단계만으로 추론

Results

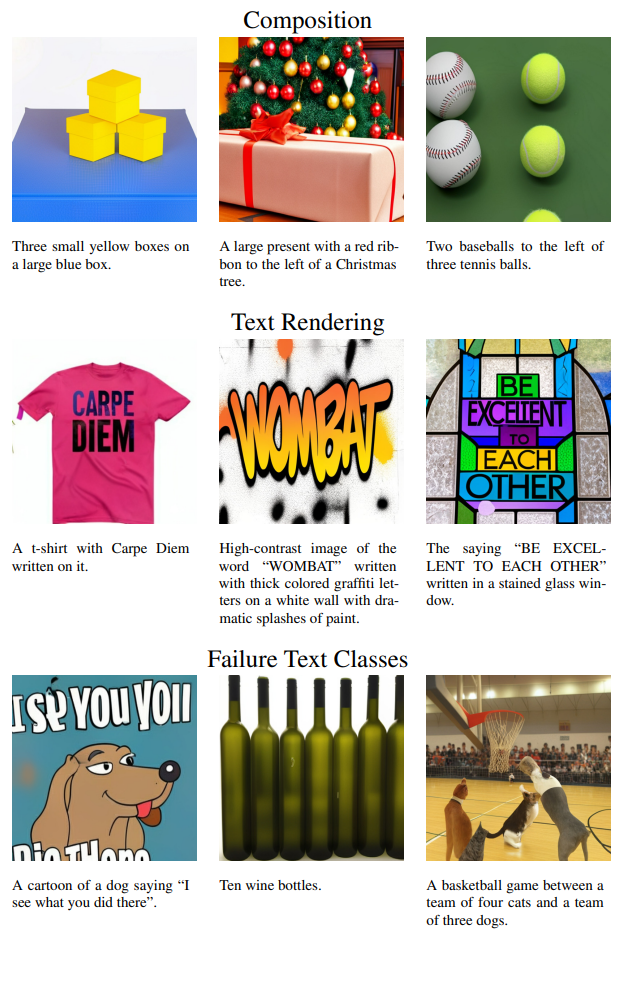

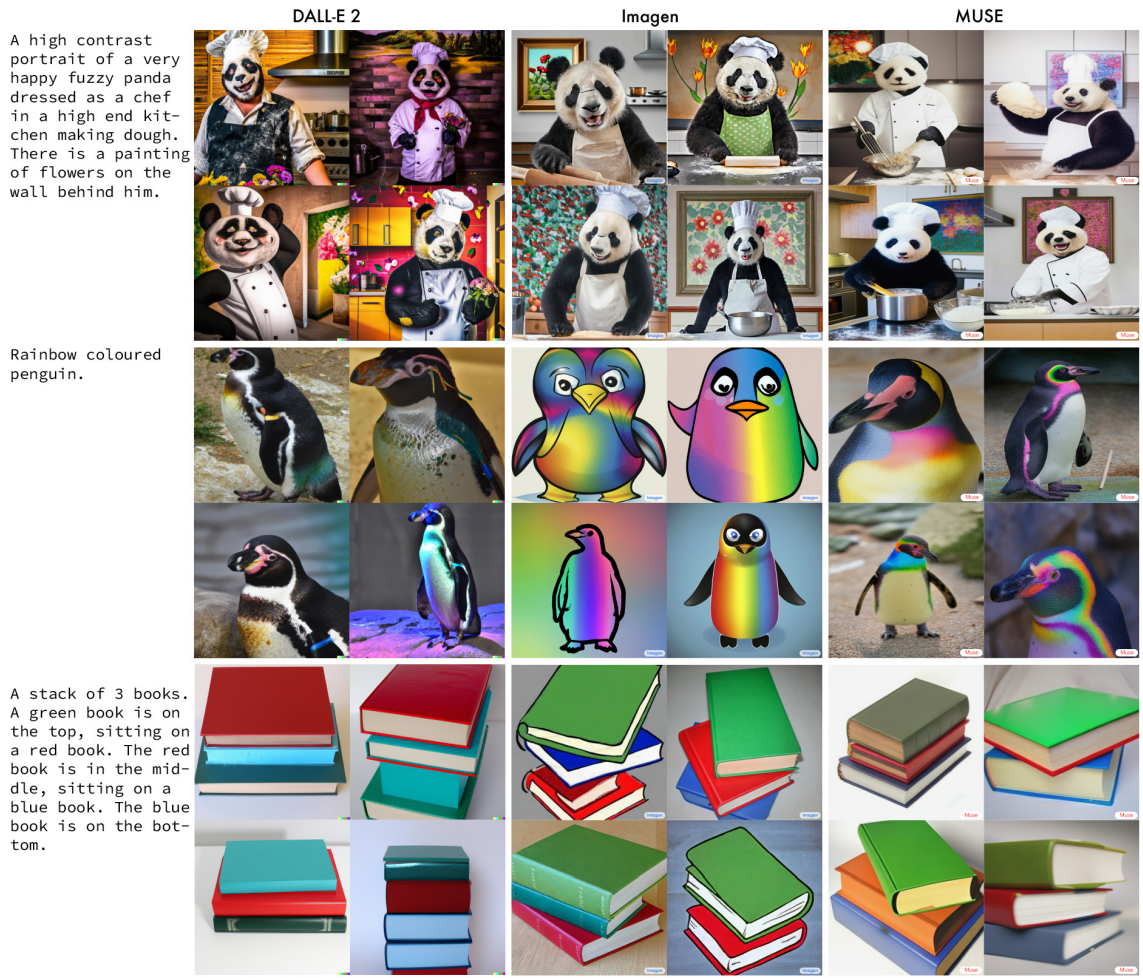

Qualitative Performance

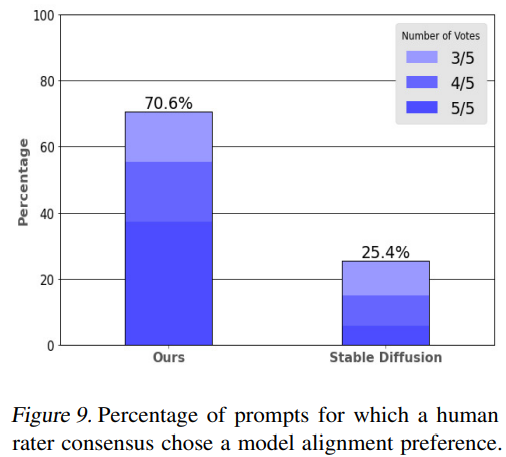

Quantitative Performance

Image Editing

별도의 inversion이나 finetuning 없는 이미지 편집, 인페인팅, 아웃페인팅 지원

'논문 리뷰 > Vision Transformer' 카테고리의 다른 글

| Segment Anything (SAM) (0) | 2023.04.09 |

|---|---|

| Token Merging: Your ViT But Faster (0) | 2023.04.06 |

| Cut and Learn for Unsupervised Object Detection and Instance Segmentation (0) | 2023.01.31 |

| Scalable Diffusion Models with Transformers (DiT) (0) | 2022.12.24 |

| MatteFormer : Transformer-Based Image Matting via Prior-Tokens 논문 리뷰 (0) | 2022.07.04 |

| Mask DINO: Towards A Unified Transformer-based Framework for Object Detection and Segmentation 논문 리뷰 (1) | 2022.06.14 |