Abstract

Transformer decoder layer 간의 높은 선형성을 식별하고 이를 활용할 수 있는 방법 제안

[arXiv](2024/05/19 version v1)

Analysis of Pretrained Architectures

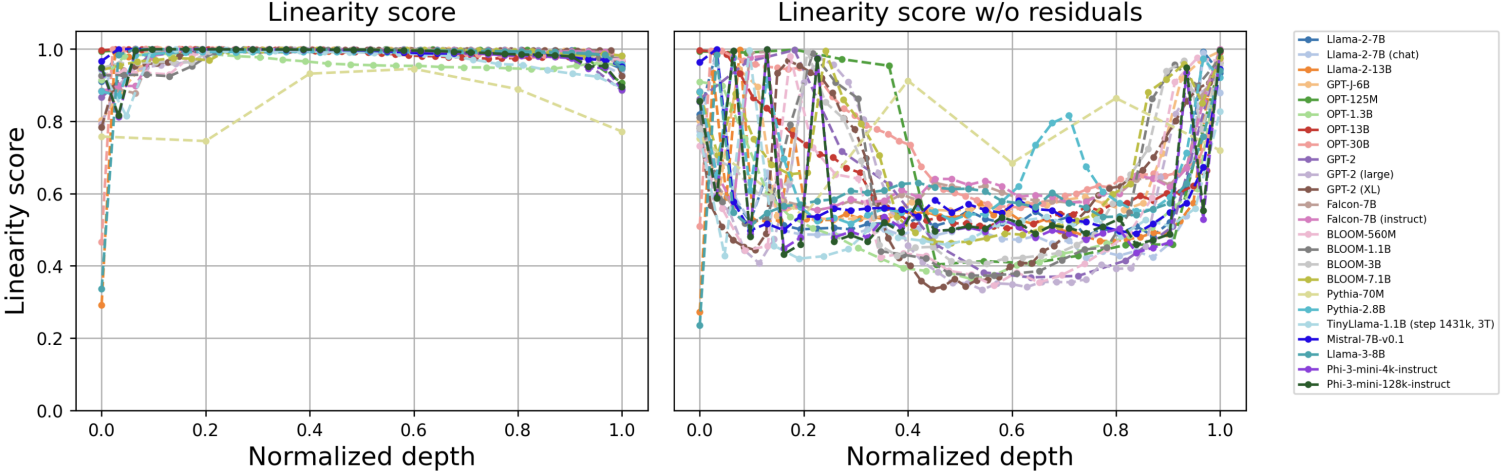

Linearity Score

선형성 점수는 정규화된 행렬 X̃, Ỹ가 있을 때, 선형 변환 A를 적용하여 차이의 최솟값을 구하고 그것을 1에서 뺀다.

레이어 입, 출력 임베딩 세트에 대해 선형성 점수를 계산한다.

놀랍게도 거의 모든 transformer decoder의 선형성 점수가 1에 가까웠다.

Residual stream을 빼면 선형성이 상당히 감소했다.

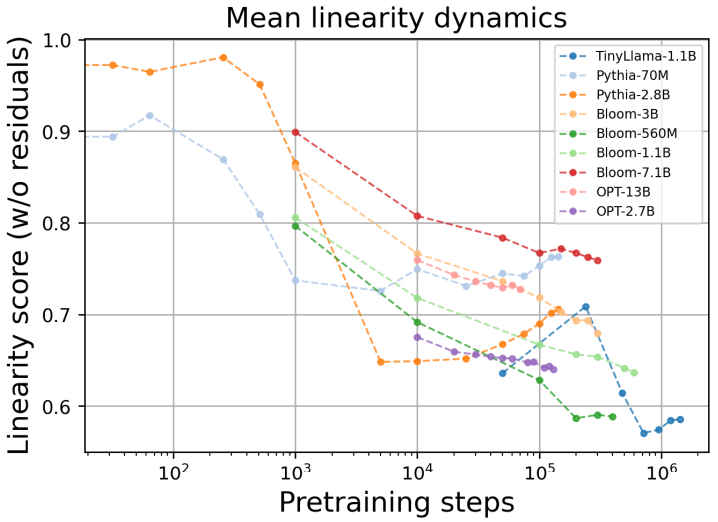

Linearity Dynamics at Pretraining and Fine-tuning

Pre-training을 진행할수록 선형성이 감소.

반면에 fine-tuning은 모든 모델들의 선형성을 증가시켰다. (Fine-tuning이 대부분 특정 sub-task를 위해 진행되기 때문인 듯)

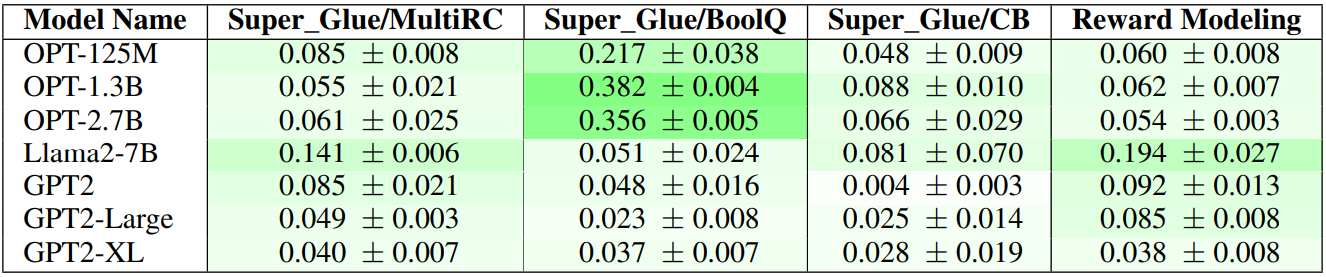

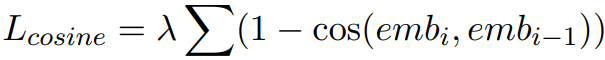

Improving Linearity with Regularized Pretraining

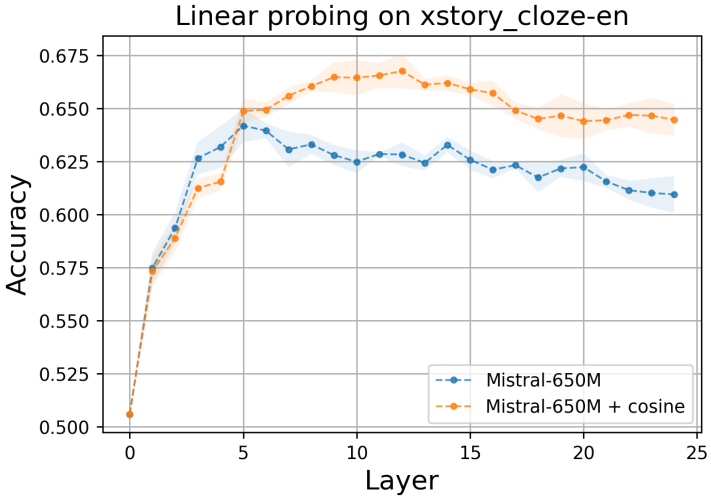

Loss에 cosine regularization term을 추가하여 훈련하면 선형성이 상당히 낮아졌다.

이는 실제 linear probing 성능에도 영향을 미쳤다.

하지만 이는 상당히 모순적인 결과이다. 임베딩 간의 코사인 유사도를 높이는 손실이 오히려 선형성을 낮춘다고?

연구진도 이 현상에 대해 확답하지 못하고 추가 연구가 필요하다고 했다.

Exploiting Linearity for Pruning

선형성이 높은 레이어를 가지치기하면 성능을 크게 저하시키지 않고 모델 크기를 줄일 수 있다.

또한 잘린 레이어를 선형 근사로 대체하고 증류 손실을 통해 추가로 훈련하면 더 성능 저하를 줄일 수 있다.