[arXiv](2024/01/08 version v1)

Model Architecture

Switch Transformer에서 사용한 switch 기반 MoE를 사용한다.

또한 원래 2개의 mamba block이 1개의 transformer block과 대응하는데, 위 그림에도 나오듯이 MoE를 추가하면 transformer block과 1대1 대응된다.

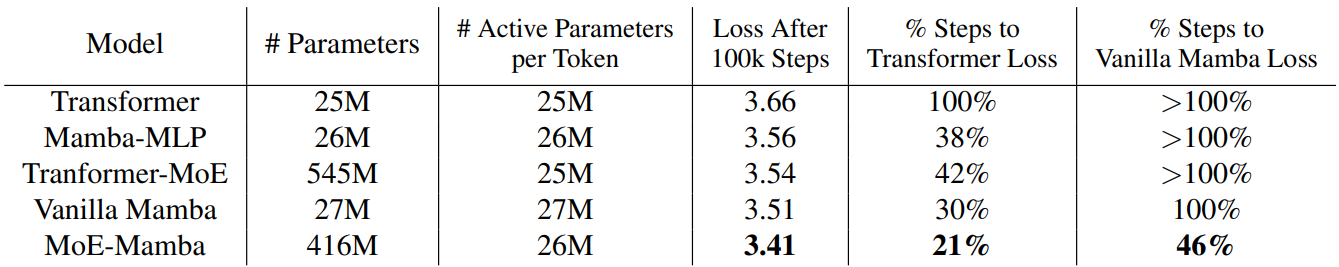

Main Results

'논문 리뷰 > Mamba' 카테고리의 다른 글

| Jamba: A Hybrid Transformer-Mamba Language Model (0) | 2024.04.01 |

|---|---|

| Zoology: Measuring and Improving Recall in Efficient Language Models (1) | 2024.02.28 |

| VMamba: Visual State Space Model (0) | 2024.01.24 |

| Vision Mamba: Efficient Visual Representation Learning with Bidirectional State Space Model (1) | 2024.01.22 |

| Mamba: Linear-Time Sequence Modeling with Selective State Spaces (0) | 2024.01.15 |

| Efficiently Modeling Long Sequences with Structured State Spaces (S4) (1) | 2024.01.12 |