드래그를 통해 이미지 제어

Abstract

드래그를 통해 이미지를 제어하는 DragGAN 제안

Introduction

GAN의 feature space가 모션 감독과 정확한 포인트 추적을 가능하게 할 만큼 충분히 구별적이라는 핵심 통찰을 기반으로 함.

추가 네트워크에 의존하기 않기 때문에 몇 초 밖에 걸리지 않는 효율적인 조작 가능.

학습된 이미지 매니폴드에서 수행되기 때문에 사자 입 속의 이와 같은 콘텐츠 환각 또한 가능.

Method

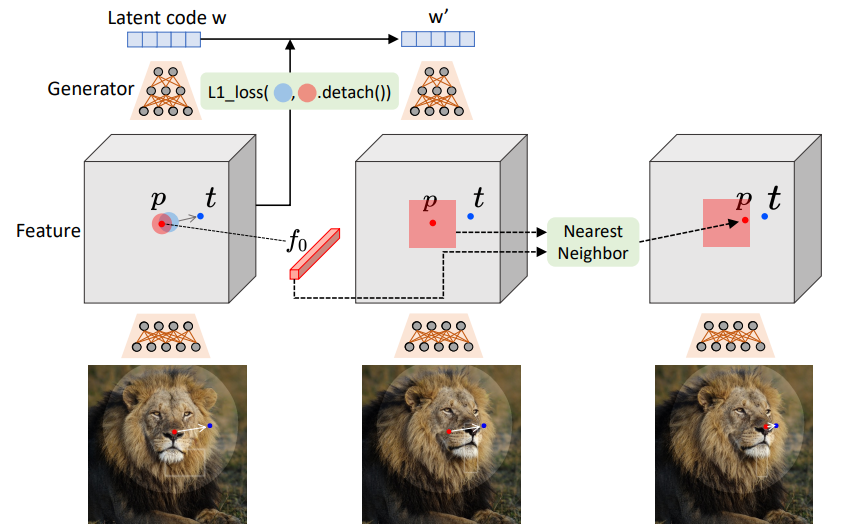

StyleGAN2 아키텍처를 기반으로 handle point가 target point에 도달하도록 구동되는 대화형 이미지 조작을 목표로 함.

Interactive Point-based Manipulation

사용자 정의 handle point pi, target point ti, mask M

모션 감독과 포인트 추적을 통해 w를 반복적으로 최적화한다.

Handle point가 얼마나 이동할지는 복잡한 최적화 역학의 영향을 받기 때문에 포인트를 지속적으로 추적해야 한다.

일반적으로 30~200회 반복.

Motion Supervision

GAN 생성기의 중간 feature가 매우 구별적이어서 간단한 손실만으로도 움직임을 감독할 수 있다는 것을 기반으로 추가 네트워크에 의존하지 않는 손실 제안.

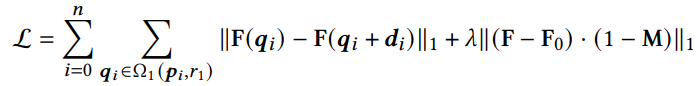

6번째 블록 이후의 feature map F를 최종 해상도와 같게 조정하고 다음과 같은 모션 감독 손실 적용:

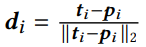

Ω1(pi, r1)은 pi까지의 거리가 r1보다 작은(빨간 원 내부) 픽셀을 의미하고, di는

종합해보면

중요한 것은 역전파 수행 시 gradient가 F(qi)를 통하여 흐르지 않게 하는 것이다.

이 손실의 목적은 w를 최적화하는 것인데, w 입장에서는 F(qi)를 F(qi+di)로 옮기는 대신 F(qi+di)를 F(qi)로 옮기는 방법으로 최적화를 시도할 수도 있기 때문이다.

실제로는 w space 대신 더 나은 편집성을 제공하는 w+ space를 최적화한다.

w+ space에서 전체적인 모양을 담당하는 초기 6개 계층의 w만 업데이트.

Point Tracking

편집된 이미지에서 handle point의 정확한 새 위치를 찍어내기가 힘들다.

보통은 optical flow 추정 모델 등을 사용하지만 GAN의 앨리어싱 등으로 인해 오차가 커질 수 있기 때문에 dense correspondence를 이용한 최근접 이웃 검색을 사용한다.

(초기 feature map = F0, 수정된 feature map = F')

둘 이상의 handle point에 대해 동일한 프로세스 적용.

Experiments

'논문 리뷰 > GAN' 카테고리의 다른 글

| StyleGAN-T: Unlocking the Power of GANs for Fast Large-Scale Text-to-Image Synthesis (1) | 2023.01.27 |

|---|---|

| Paint2Pix: Interactive Painting based ProgressiveImage Synthesis and Editing (0) | 2022.08.20 |

| Sketch Your Own GAN 논문 리뷰 (0) | 2022.08.13 |

| Rewriting a Deep Generative Model 논문 리뷰 (0) | 2022.08.12 |

| Rewriting Geometric Rules of a GAN (GANWarping) 논문 리뷰 (0) | 2022.08.10 |

| Learning to Cartoonize Using White-box Cartoon Representations 논문 리뷰 (0) | 2022.07.13 |