Cross domain translation을 full-image에서 one-path로 가능하게 한 모델

Abstract

Few-shot 초상화 스타일링을 위한 새로운 이미지 변환 아키텍처인 DCT-Net(이하 DCT)을 소개한다. DCT는 제한된 스타일 예제(~100)로 높은 충실도의 콘텐츠 합성과 복잡한 장면을 처리할 수 있는 강력한 일반성을 제공한다. 또한 부분 관찰에 의해 훈련된 평가 네트워크를 통해 전신 이미지 변환을 가능하게 한다.

Introduction

이미지 변환, 전송, 반전 모델의 발전에도 불구하고 제한된 일반화 능력, 도메인 간의 콘텐츠 누락 문제, 전신 이미지에 적용할 수 없는 문제 등으로 인해 어려움을 겪는다.

본 논문의 목표는 높은 컨텐츠 합성 능력, 강력한 일반성, 높은 확장성을 가진 새로운 초상화 스타일링 방법을 제안하는 것이다. 새로운 방법은 다양한 스타일의 초상화 변환을 수행할 수 있으며 전신 이미지 또한 적응적으로 처리할 수 있다.

논문의 주요 통찰은 다음과 같다.

- 보정 먼저, 변환 나중에

- 균형 잡힌 소스 분포

- Geometry 확장

먼저 도메인 보정 변환을 위한 솔루션, geometry 확장 모듈을 통해 분포를 보정하고 교차 도메인 변환을 위해 U-Net을 활용한다.

Method Description

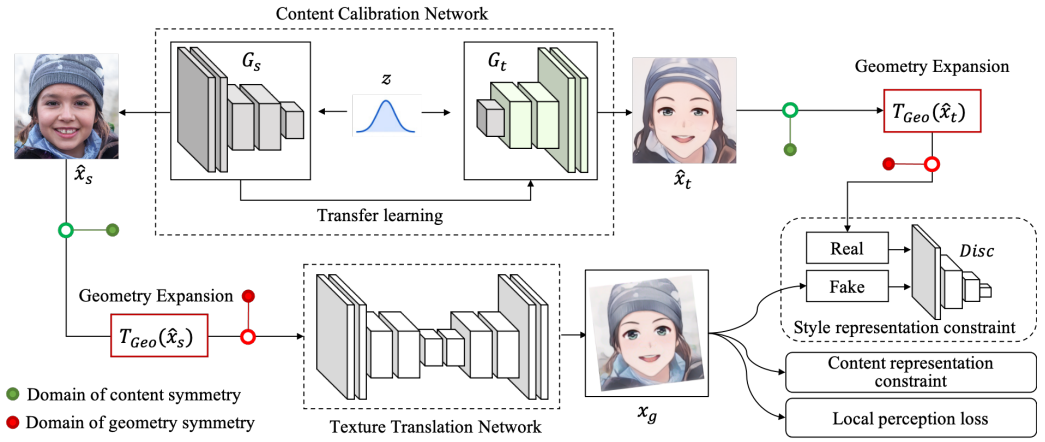

Overview

목표는 소스 도메인 Xs를 목표 도메인 Xt에 매핑하는 함수 Ms→t를 배우는 것이다.

출력 이미지 xg는 소스 이미지 xs의 content를 유지하면서 목표 이미지 xt와 유사한 스타일이어야 한다.

- Content 보정 네트워크(CCN) : 전이 학습을 통해 Gs를 조정하여 content 차원의 분포를 보정.

- Geometry 확장 모듈(GEM) : 소스 및 목표 분포의 Geometry 차원을 추가로 확장하고 다양한 축척과 회전을 가진 geometry-symmetry feature 제공

- Texture 변환 네트워크(TTN) : 보정된 분포에서 샘플링된 데이터를 사용하여 다중 표현 제약 및 local perception loss가 있는 도메인 간 대응을 학습

CCN과 TTN은 따로 훈련되며 CCN은 추론에서 사용되지 않는다.

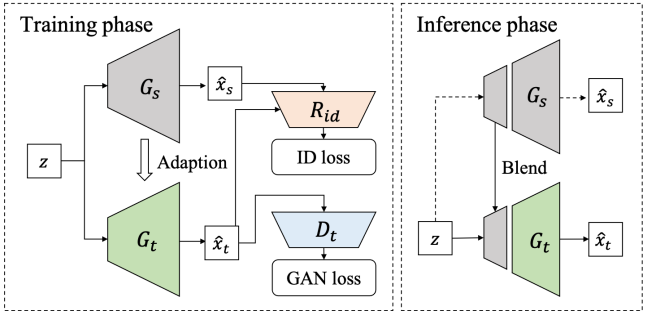

Content calibration network

이 모듈에서는 대상 샘플의 편향된 분포를 보정한다.

Gs의 복사본인 Gt를 얼굴 인식 모델 Rid(Arcface)와 Dt를 통해 목표 도메인에 미세 조정하고 추론 단계에서는 레이어 스와핑을 한다.

여기서 중요한 점은 CCN의 훈련 과정에서 실제 얼굴 이미지를 전혀 사용하지 않는다는 것이다. 이로 인해 예시 기반 훈련보다 실제 분포에 더 근사할 수 있으며, 또한 소스 도메인의 분포와 목표 도메인의 분포가 상대적으로 대칭이므로 도메인 대응을 더 쉽게 학습할 수 있다.

Geometry expansion module

소스 도메인(FFHQ)의 이미지는 모두 정렬되어 실제 데이터와 맞지 않다.

변환 Tgeo를 모든 샘플에 적용하여 실제 데이터 추론에 더 적합하게 만든다.(scale[0.8, 1.2], rotation[−𝜋/2 , 𝜋/2])

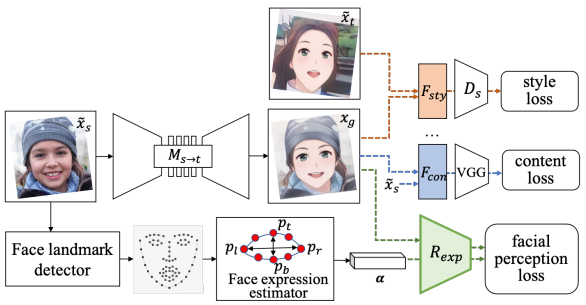

Texture translation network

TTN은 보정된 두 도메인(X̃s, X̃t) 간의 대응 관계를 학습한다. CCN은 잠재공간 z에서 정렬된 이미지 쌍을 생성할 수 있지만 content 세부 정보를 보존할 수 없고 실제 이미지에 적용할 수도 없다.

재구성된 두 도메인의 texture 정보는 충분하지만 매핑이 부정확한 점을 고려하여 U-Net으로 픽셀 수준의 texture 변환을 학습한다. 입력으로 geometry 확장된 소스 이미지(FFHQ)를 받는다.

아키텍처 그림에는 직관을 위해 모든 샘플이 같도록 표시했지만 목표 도메인 샘플 이미지는 style 표현 학습을 위한 용도이므로 실제 훈련은 unpair 데이터로 진행된다.

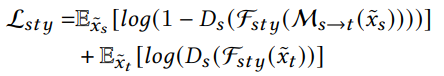

Multi-representation constraints

이 논문의 표현 분해 방식에서 영감을 받아 feature 및 surface 분해를 통해 x̃t및 xg에서 스타일 표현 Fsty를 추출하고 판별자 Ds를 사용하여 Ms→t이 xg를 x̃t와 유사한 스타일로 합성하도록 가이드한다.

VGG 공간에서의 L1 거리를 통해 content loss 계산

Facial perception constraint

네트워크가 과장된 표현을 가진 스타일화 초상화를 생성하도록 장려하기 위해 보조 표현 회귀분석기 Rexp를 도입한다. Rexp를 통해 얼굴 표정을 제한함으로써 본질적으로 local 구조 변형을 자극하고 얼굴 구성요소에 더 많은 주의를 기울인다.

Rexp는 특징 추출기 위의 n개의 회귀 헤드로 이루어져 있고 특징 추출기와 Ds는 PatchGAN 아키텍처를 따른다.

αi ∈ [0, 1]는 각각의 표현 피라미터를 의미한다. 논문에서는 n=3으로 하고 각각 왼쪽 눈, 오른쪽 눈, 입의 열린 각도로 정의했다. αi는 각 구성요소의 경계 상자의 종횡비를 이용하여 쉽게 구할 수 있다.

Training

보정된 각각의 도메인에서 x̃s, x̃t가 주어지면 TTN은 다음의 손실함수로 훈련된다.

Total variation loss Ltv는 생성된 이미지를 평활화하며 다음과 같이 계산된다.

Inference

DCT는 관행적인 처리 방법과 달리 one-path로 스타일화 결과를 생성할 수 있다.

Experimental Results

Implementation Details

CCN을 먼저 훈련하고 TTN을 훈련

StyleGAN2 config-f 256×256 FFHQ

모델 혼합 k = 4

Content feature는 VGG16 conv{4_4}에서 추출

Adam optimizer

Rexp는 기존 얼굴 랜드마크 감지기와 결합하여 레이블이 지정된 속성으로 훈련, 미리 학습시켜 TTN 학습에 사용

Results

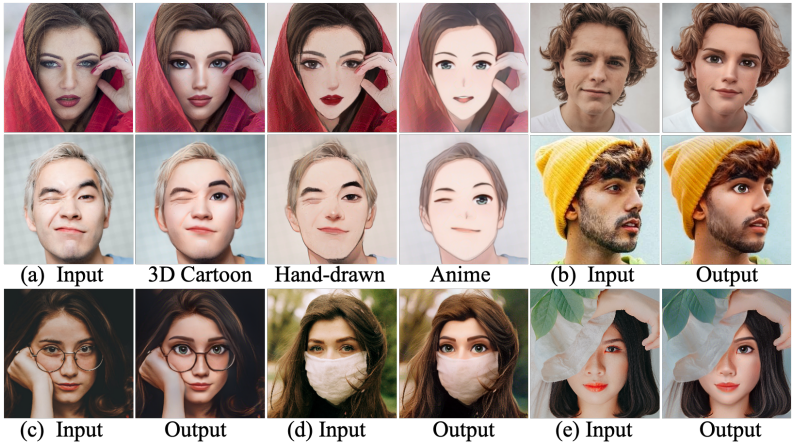

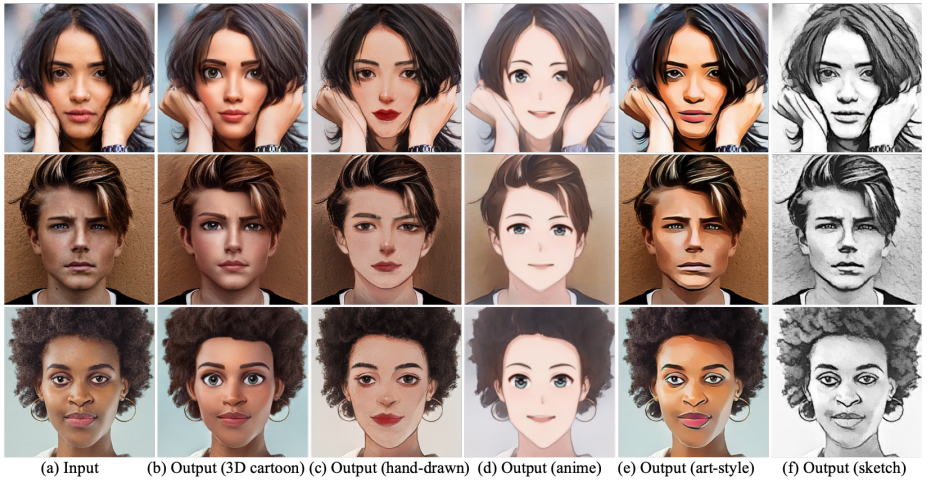

다양한 스타일과 복잡한 장면(b~e)에서 합성된 결과

다른 모델들과 비교

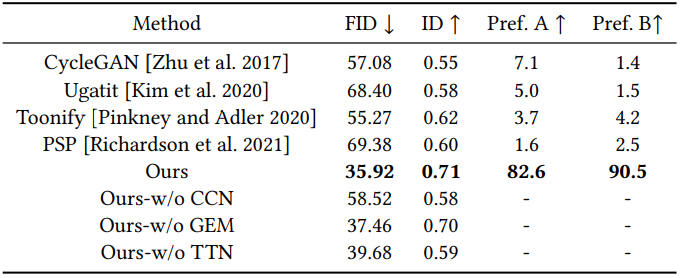

정량적 비교

Ablation

전체 이미지에서 다양한 스타일 적용

'논문 리뷰 > GAN' 카테고리의 다른 글

| Rewriting a Deep Generative Model 논문 리뷰 (0) | 2022.08.12 |

|---|---|

| Rewriting Geometric Rules of a GAN (GANWarping) 논문 리뷰 (0) | 2022.08.10 |

| Learning to Cartoonize Using White-box Cartoon Representations 논문 리뷰 (0) | 2022.07.13 |

| StyleSpace Analysis: Disentangled Controls for StyleGAN Image Generation 논문 리뷰 (1) | 2022.07.01 |

| ReStyle: A Residual-Based StyleGAN Encoder via Iterative Refinement 논문 리뷰 (0) | 2022.07.01 |

| Cross-Domain Style Mixing for Face Cartoonization 논문 리뷰 (0) | 2022.06.30 |